AIエージェントの性能を下げてしまう9つの落とし穴

これからお伝えする問題は、もしかすると身近に感じるかもしれません。 数ヶ月前、私たちはあるスタートアップと協力して、カスタマーサポート業務を支援するAIエージェントを開発していました。このエージェントの役割は、スタッフのスケジュール調整と、顧客からのサポートリクエストの管理でした。しかし、技術チームはエージェントの精度やレスポンス速度を改善しようと、何時間もデバッグに費やしたものの、思うような成果が得られませんでした。顧客を満足させるレベルに到達できず、開発工数とOpenAIの利用料だけを消費し続け、改善を願うばかりの状態。 こうした状況は、決して珍しいことではありません。AIエージェントを導入しようとする多くの企業が直面する問題です。 Ichizokuのエンジニアリングチームは、さまざまな規模・複雑さのAIプロジェクトに取り組んできました。その過程の中で、AIエージェントのデバッグ時に陥りがちな落とし穴を学びました。本記事では、AIエージェントのパフォーマンスと精度を向上させる際に企業が犯しがちなミスを紹介します。加えて、実際のプロジェクトで得た知見や、すぐに実践できる戦略、他業種のチームと協力する中で培った教訓もお伝えします。 AIエージェントの開発を始めたばかりの方も、すでに運用していて最適化を目指している方も、この記事を読むことで時間・費用・ストレスの削減につながるはずです。 それでは、AIエージェントのパフォーマンス最適化でよくある課題を見ていきましょう。以下の通りです。 1. LLMを効果的な「判定者」として適切に整合させていない 問題LLMを評価者として使用する場合、その評価基準が人間(使用者)の評価基準と合致していないと、意図していない結果や、信頼性の低い評価を招く可能性があります。モデル内部の「判定者」が、人間が正確だと思う、または価値があると考える基準を反映していない場合、誤った結果を最適だと判定する危険性があります。これによって、見た目には80%や90%の精度でうまくいっているように見えるシステムが、実際の現場では、ほとんどがランダムな回答で稼働していることに気づくことになります。 解決策評価プロンプトが、人間のフィードバックと厳密にテストされていることを確認しましょう。LLMが「良い」と判断するものは、人間の評価基準と密接に合致させておくべきです。このプロセスでは、評価基準を洗練させたり、モデルの判断を検証するために人間が介入する仕組みを組み込む必要があるかもしれません。LLMの評価能力を合致させることは、見落としてはならない基礎的なステップです。 2. テスト時の統計的厳密性に欠けている 問題一度きりの実験結果を決定的なものと判断してしまうと、誤った結論を導き出すリスクがあります。結果が良く見えても、それが統計的な偶然や単なる誤差である可能性があるためです。検証を怠ると、データのノイズを本物のパターンと誤認し、不適切な最適化を行ってしまう恐れがあります。その結果、プロジェクトの予算確保やMVP(最小限の実用的製品)の検証のために、貴重な時間とリソースを浪費してしまう可能性が生まれてしまいます。 解決策実験は一度きりでなく複数回行い、結果をしっかりと検証しましょう。ブートストラップや有意性検定といった統計的手法を活用し、得られた改善が偶然ではなく本当に意味のあるものかを確認することが重要です。このような厳密なアプローチを取ることで、ランダムな変動による誤った判断を防ぐことができます。しかし、こうした統計的な厳密さは、ソフトウェアエンジニアがAIエンジニアリングに移行する際に見落とされがちなポイントでもあります。しっかりとした検証を行う習慣を身につけることで、より信頼性の高い成果を得ることが可能となるでしょう。 3. 実験コストが膨らみ過ぎている 問題実験を続けているうちに、コストが想定以上に膨らんでしまうことがあります。実験結果を適切に保存したり、生産性の低い方法を排除したりする仕組みがないと、無駄な処理が増え、予算を使い果たしてしまう恐れがあります。例えば、APIの使用制限(レートリミット)に頻繁に引っかかったり、冗長なテストを繰り返したりすると、貴重な時間とコストを浪費することになります。こうした管理不足が続くと、実験を継続することが難しくなり、プロジェクト全体の進行が大きく遅れる可能性も出てきます。 解決策実験コストを最適化し、効率的に進めるための対策を取りましょう。 4. モデルのサイズとタスクの複雑さが合っていない 問題モデルのサイズとタスクの難易度が適切に釣り合っていないと、期待するパフォーマンスが得られないことがあります。例えば、小さなデータセットに対して過度に大きなモデルを使用すると、データに過剰適合(オーバーフィッティング)し、汎用性のない不安定な結果を生み出す可能性があります。逆に、非常に複雑なタスクに対して小さなモデルを使うと、情報を十分に学習できず、精度の低い結果しか得られないことがあります。こうしたミスマッチは、リソースの無駄遣いにつながるだけでなく、AIの活用そのものが失敗する原因にも繋がります。 解決策データの量やタスクの複雑さに見合ったモデルを選択しましょう。 例えば、データが極端に少ない場合(20~40程度)は、プロンプトエンジニアリングやキャッシュなどの代替手段を検討し、少ないリソースでより良い結果を得られる場合があります。推測や仮定を避け、最適なアプローチを決定するために明確な評価基準を設定することが重要です。 5. ファインチューニング時にAPIレート制限に達してしまう 問題OpenAIのファインチューニングAPI(または同様のサービス)を使用していると、APIレート制限にすぐに達してしまい、作業が滞ることがあります。このため、反復的なサイクルが中断され、実験が遅くなることがあります。迅速な試行錯誤は、結果を最適化するために不可欠です。 解決策ファインチューニングの進め方を工夫し、APIレート制限の影響を最小限に抑える方法を採りましょう。 6. GPUの構築にこだわり過ぎて、迅速な実験のためのインフラが整っていない 問題GPUの構築にばかり注力しすぎると、実験のスピードや反復性が低下してしまいます。多くのチームがハードウェアの最適化にこだわるあまり、スムーズな試行錯誤を支えるインフラやプロセスの整備を後回しにしがちです。その結果、実験の効率が悪くなり、AIエージェントの改善が遅れてしまいます。 解決策実験を頻繁に行える環境を整え、最初からスケールに対応できるインフラを構築しましょう。 初期段階で適切なツールとプロセスに投資することで、素早い反復・最適化が可能になります。 7. 新しいモデルやインフラへの移行の難しさを過小評価している 問題AI技術は急速に進化しており、多くのオープンソースの選択肢が提供される中で、AIエンジニアはコスト管理やパフォーマンス向上のためにさまざまな選択肢を検討できます。しかし、すべてのユースケースに最適なモデルが1つだけとは限りません。たとえば、OpenAIの独自モデルからLLaMAのようなオープンソースのモデルに移行することは簡単ではなく、移行後には大きな変化が起こる可能性があります。プロンプト、評価フレームワーク、データパイプラインなど、さまざまな部分に大きな調整が必要になり、APIの小さな違いでも大きな問題を引き起こすことがあります。 解決策インフラを柔軟かつ移植性を考慮して設計しましょう。 インフラを未来を見越して設計することで、移行時の問題を最小限に抑えスムーズに進行することが可能になります。 8. プロンプトエンジニアリングの体系的アプローチを欠いている 問題静的なプロンプトと動的に取得されたプロンプトを選ぶ過程は、非常に時間がかかってしまいます。明確な戦略がないと、チームはどちらが最適かを試行錯誤し続けることになり、その試行錯誤が何週間も続くことがあります。このようなプロセスでは、進展がほとんど見られず、明確なプロンプトエンジニアリング戦略が欠けていると、進行が遅れるだけでなく、プロンプト管理に不必要な複雑さが生まれてしまいます。 解決策プロンプト戦略を評価し、標準化するための体系的なアプローチを採用しましょう。 この意思決定プロセスは、最も混乱が生じやすい部分でもあり、最適化による効果を得やすい部分でもあります。 9. モデル出力の統合・集約が適切に行われていない 問題複数のモデルを使用したり、異なるプロンプト戦略を実験したりする際、結果をどのように組み合わせるかを決めることが難しいことがあります。明確な計画がない場合、矛盾する出力に圧倒され、意味のある洞察を得ることがほぼ不可能になります。AIエージェントのパフォーマンスに基づいて意思決定を行うためには、出力結果を適切に集約することが非常に重要です。 解決策実験を実行する前に、集約戦略を確立しましょう。 集約方法に一貫性を持たせることで、出力結果が実行可能で透明性のあるものになります。これが欠けていると、ノイズばかりが強調され、貴重な洞察を得ることができなくなります。

AIロードマップの道を切り拓く:Ichizokuと共に未来を築こう

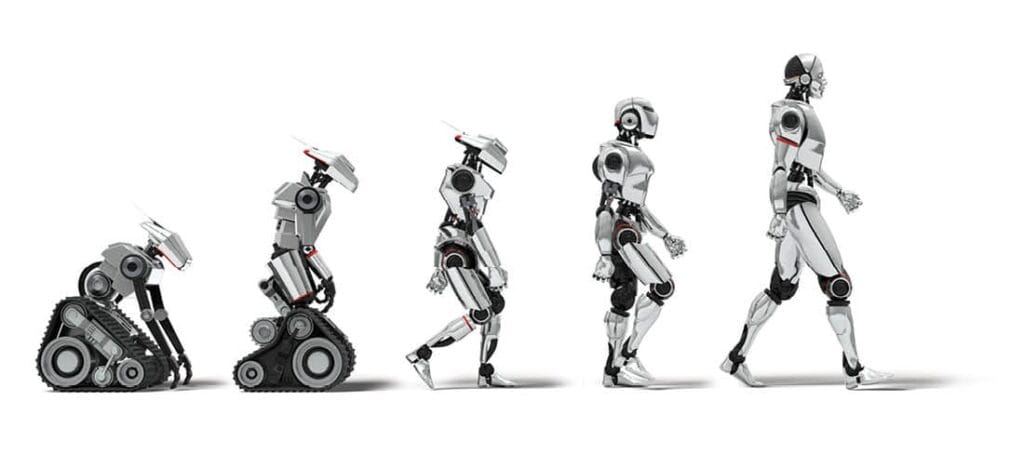

2019年の面白いニュースを覚えていますでしょうか?「変なホテル」、多くのスタッフがロボットであることを売りにしていたが、色んなトラブルもあったニュース。宿泊施設で導入された「ちゅーりー」という名前の仮想アシスタントロボットが、予期せぬ問題を引き起こし、最終的に全客室から撤去されることとなった。この騒動の発端は、宿泊客からの苦情だった。ある宿泊客は、就寝中に「ちゅーりー」に何度も起こされたと不満を述べた。原因は、客のいびきに反応したロボットが「申し訳ありませんが、聞き取れません。ご要望をもう一度おっしゃってください」と繰り返し話しかけたためだった。さらに、別の宿泊客はTripAdvisorのレビュー欄に、「ちゅーりー」が宿泊客同士の会話に勝手に割り込んでくるという不満を投稿した。 その出来事から6年。テクノロジーの世界でまた最も注目を集めたな2文字、「A」と「I」。飛躍的な技術の進展・成長でAIを受け入れずにテクノロジーの未来を生き抜くことはできないと、誰もが知っている2025年に至った次第です。多くの企業・組織もその波に乗ってこの数年でChatGPTを導入し、独自のチャットボットを作成しましたが、これはAIの可能性のほんの一部に過ぎません。次の10年で差別化を図るには、包括的なAIロードマップの開発が不可欠です。このロードマップは、顧客向けアプリケーションだけでなく、内部プロセス、意思決定フレームワーク、戦略的計画も含むべきです。データインフラ、人材開発、倫理的考慮事項、部門横断的な統合など、重要な領域に取り組む必要があります。企業全体でAI採用に戦略的にアプローチすることで、組織は単純なチャットボットをはるかに超える変革の可能性を解き放ち、イノベーション、効率性、競争優位性を推進できるのです。 包括的なAIロードマップとIchizokuにできること 包括的なAIロードマップ、言うのが簡単で作るのが写真がない数千ピースのパズルに向き合うような、気の遠くなるような作業に感じるかもしれません。幸いなことに、AIロードマップを作成することはロケット科学ではありません。しっかりと計画を立てることで、AIへの好奇心を具体的で測定可能なビジネス価値へと変えることができます。 基本から始めよう: なぜAIロードマップが必要なのか 真実を言うと、AIは最先端のアルゴリズムを導入したり、最新ツールを購入したりするだけのものではありません。戦略、企業文化、そして業務プロセスを整え、スケールで価値を生み出すことが重要なのです。ロードマップがなければ、多くの企業は結果を出せない中途半端な実験に終わってしまいます。 AIロードマップをGPSのようなものだと考えてください。それは次のことを教えてくれます: まずは作成、その後の運用されたAIロードマップは、AIを単なるツールとしてではなく、組織のあらゆるレベルで真のデジタルトランスフォーメーションを促進する触媒として活用し、その変革力を最大限に引き出せるようにビジネスを位置付けます。 Ichizokuのアプローチ IchizokuがITコンサルティング、デジタルトランスフォーメーション、エンタープライズ戦略の最前線で経験を積んだチームであり、企業の技術的成長を可能にし、加速させる支援を行っています。IchizokuがAIを困難なパズルから実行可能なロードマップに変える方法はハイレベルでまとめる以下の通りです: 文化的な整合性を確保する – AIを効果的に活用するために、人材、プロセス、ワークフローを準備します。 現在の状況から始める – 現在の能力、目標、課題、ギャップを評価します。 AIが測定可能な価値を提供できる重要な領域を定義する – 派手な機能を追加するのではなく、ビジネス課題を解決することに焦点を当てます。 AI戦略を既存のエコシステムに統合する – 進行中のデジタル化イニシアチブを中断させるのではなく、強化することを目指します。 具体的にAIロードマップの6つの主要なワークストリームを詳しく見ていき、それぞれにおいてIchizokuがどのように重要な役割を果たせるかを解説します。 ① AI戦略:北極星を定義する 全体像から始めるのが我々のアプローチです。組織はAIを使って何を達成したいと考えていますか?業務の効率化、顧客体験の向上、あるいは全く新しい収益源の開拓を目指していますか?AI戦略は、全体的なビジネス戦略と一致しているべきです。 これは一度きりの作業ではありません。あなたの戦略は、ビジネスの成長とAIの取り組みから学びながら進化します。これをあなたの北極星として捉え、すべての意思決定を導くものと考えましょう。 Ichizokuが提供できる支援:Ichizokuは豊富な業界経験を活かし、AI戦略に適した北極星の指標を定義するためのコンサルティングとガイドを提供できます。あなたのビジネス目標に共鳴する実行可能なシナリオとベストプラクティスを提案し、AIの取り組みが実用的であり、広範な目標と一致するようにサポートします。 ② AIの価値:ROIを見せて AIは、その提供する価値が大きいほど有効です。特定の課題や機会に対応するいくつかのインパクトの大きいユースケースから始めましょう。パイロットを実施し、成功を測定し、アプローチを改善します。 時間が経つにつれて、焦点を短期的な成果から、長期的な価値を継続的に提供するAI製品のポートフォリオ構築へと移行します。「単発プロジェクト」から持続可能なAIエコシステムへの移行こそが、真の成果を生む場所です。 Ichizokuが提供できる支援:戦略的なテクノロジーパートナーとして、インパクトの大きいユースケースを特定し、AIの価値を組織内で検証するための小規模なPOC(概念実証)の実施を支援します。私たちはエンドツーエンドのサポートを提供し、AIの取り組みが効果的にスケールするようにサポートします。これにより、大規模な内部チームを構築することなく、アジャイルに成果を達成できます。 ③ AI組織:Actionチームを作る AIはある部門で進めるミッションではありません。組織全体で適切なスキル、リソース、そして協力が必要です。まず、どのような専門知識が必要かを特定しましょう。それらの能力を社内で構築しますか、それとも外部パートナーに頼りますか? 実践コミュニティを確立し、全員を調整します。AIの取り組みが拡大するにつれて、役割、責任、プロセスが明確なより正式な運営モデルへと進化させることができます。 Ichizokuが提供できる支援:IchizokuはAIスキルの人材サービスを提供し、トップクラスのAI人材と専門知識にアクセスできるようにします。社内チームをゼロから構築する手間を省き、AIの取り組みでのインパクトのある成果と成功を確実にします。必要に応じてリソースをスケールできる柔軟性を提供し、AIの旅をスムーズでコスト効果の高いものにします。 ④ AIエンジニアリング:堅実な基盤を作る 揺れる地盤の上に高層ビルを建てることはできません。同じことがAIにも当てはまります。まずはサンドボックス環境を設定して実験し、再利用可能なアーキテクチャ特定がベースライン。スケールを拡大する際は、ModelOps、AIの可観測性、プラットフォームエンジニアリングなどの実践に焦点を当て、AIの取り組みが堅牢でスケーラブルであることを確保します。 Ichizokuが提供できる支援:Ichizokuでは、ビジネスのニーズに合わせたカスタマイズされたソリューションを設計します。私たちの目標は、最適な効率と効果を提供し、AIの基盤が強固でスケーラブル、そして将来に対応できるものとなるよう支援することです。 ⑤ AIデータ:ゴミを入れればゴミが出る AIは、与えられたデータが良いものであるかどうかによって、その効果が決まります。組織のデータ準備状況を評価し、AIのユースケースに対応できるようデータの準備プロセスを実施しましょう。進行するにつれて、データの可観測性や高度な分析能力に投資し、データが信頼性があり、実行可能であることを確保します。 Ichizokuが提供できる支援:Ichizokuのアプローチとしてテストデータ生成からすべてのデータ課題に対応するよう設計されています。高度な分析とRAGサービスを提供します。ハルシネーションの測定できるようにArizeというプラットフォームでリアルタイムでAIシステムの監視・評価を可能にします。 ⑥ AIの人材と文化:変化は難しい 正直に言いましょう—AIは人々の働き方を変革します。従業員は新しいスキルを学ぶ必要があり、いくつかの役割はシフトし、組織文化も適応しなければなりません。まずは、タレントギャップを特定し、それに対処するための計画を立てましょう。変革管理戦略を実施して移行をスムーズにし、AIが従業員に与える影響を継続的に評価します。 Ichizokuが提供できる支援:要相談 まとめ AIは未来のものではなく、すでにここにあります。重要なのは、あなたがその可能性を活用する準備ができているかどうかです。準備が整っていることを確認しましょう!Ichizokuは、あなたのAIロードマップの旅をサポートするためにあります。一緒に進めていきましょう。

「RAGとは?生成AIの基本とハルシネーションの解説」初心者でもわかる!

AI分野では、RAG、ハルシネーションといった用語が頻繁に登場します。しかし、これらの概念は一体何を意味しているのでしょうか? そして、なぜ重要なのでしょうか?ここでは、AIに関するこれらの最も興味深く、時には難解な側面について、わかりやすく解説していきます。 いきなりRAGなんてやめましょう。まずは少しAIの話しします AIが必要な理由は、私たちの生活を便利にしたり、問題を解決したりするためです。たとえば、AIは大量の情報を瞬時に処理して、私たちが知りたいことに答えを出すことができます。しかし、時にはAIが正しくない情報を作り出してしまう「ハルシネーション」という現象があります。これは、AIが情報を持っていないときに、適当な答えを出そうとして間違えることです。つまり、AIが「作り話」をする、もしくは「推測」することです。 ちょっとした面白い例でRAGを理解しましょう 2000年代初頭の宇多田ヒカルの「Can You Keep A Secret?」のミュージックビデオを覚えていますか?未来的な世界観の中で、ロボットが宇多田に恋をし、彼は彼女との日常的なやり取りで使われた物を通してさまざまな記憶を思い出していきます。その物たちはロボットにとって記憶を呼び起こす手掛かりとなり、関係をさらに視覚化する助けとなっています。これはRetrieval-Augmented Generation (RAG)のメタファーとも言えます。簡単に言えば、RAGはAIにおいて、サポートとなるデータや記憶のような情報を呼び出すことで、応答の内容を豊かにし、文脈に沿ったものにする技術です。この場面では、車が記憶の手掛かりとして機能し、ロボットが宇多田との過去をシミュレーションできるようにしています。RAGの目的である「生成AIと検索サポートメカニズムの統合によるより正確に人間らしい応答」を反映していると言えるでしょう。 そもそもハルシネーションが起こる理由を整理しましょう ハルシネーションの原因をまとめると以下のとおり 訓練データの不足: AIは大量のデータから学習しますが、十分な関連情報がない場合、知らない質問に対して間違ったり、意味のない答えを生成したりすることがあります。 言語の複雑さ: 言語は複雑で、文脈によって意味が変わることがあります。AIが回答を生成しようとするとき、文脈やニュアンスを誤解して、もっともらしいけれど正しくない答えを出すことがあります。 過剰一般化: AIは、見たことのあるデータから一般的なパターンを学びますが、異なる文脈に対してそのパターンを適用してしまうことがあります。例えば、特定のタイプのテキストから学んだことを、別の質問に誤って使ってしまうことがあります。 ではRAGを登場させよう: RAG(情報検索強化生成)は、AIがより正確な答えを出せるようにする方法です。これは、AIが「信頼できる情報源」から情報を取り出すことを意味します。たとえば、AIが自分だけでは答えを見つけられないとき、RAGを使うことで、別のデータベースや知識の集まりにアクセスして、必要な情報を探し出して答えを提供することができます。 RAGの重要性 RAGはAIの信頼性を向上させ、誤回答を減らすのに役立ちます。特に、カスタマーサービスや検索エンジンなど、正確な情報が求められる場面で大いに役立ちます。 以下は、RAG(情報検索強化生成)がAIの結果を改善する方法の簡単な例です: チャットボットの例: お客さんがチャットボットに特定の製品についての情報を尋ねると、AIはその製品についての詳しい知識を持っていないかもしれません。しかし、RAGを使うことで、チャットボットは最新の製品情報や仕様が入ったデータベースにアクセスできます。これにより、チャットボットは正確で関連性のある回答を提供でき、お客さんの満足度や信頼を高めることができます。チャットボットがPDFのような知識データベースと連携すると、詳しくて整理された情報にアクセスできるようになります。たとえば、ユーザーが技術的な製品について質問すると、チャットボットはPDFに保存された製品マニュアルや研究論文、ユーザーガイドから関連する部分を取り出すことができます。これにより、チャットボットは正確で適切な答えを提供できるようになります。RAGを活用することで、チャットボットはこれらのPDFから特定のデータを取り出すだけでなく、複雑な情報をまとめることもできます。これにより、ユーザーが理解しやすくなります。たとえば、「最新モデルの安全機能は何ですか?」と誰かが尋ねた場合、チャットボットは製品マニュアルのPDFから関連する詳細を抽出し、包括的で正確な回答を提供できます。 画像生成の例: ユーザーが「空飛ぶ車がある未来の都市」といった説明をもとに画像を生成するAIを想像してください。AIが自分の訓練データだけに頼ると、正しい画像を作るのが難しくなるかもしれません。RAGを使うことで、AIは未来の都市や空飛ぶ車に関連する既存の画像や概念、スタイルを取り出すことができます。この取り出した情報と自分の生成能力を組み合わせることで、より魅力的で正確な画像を作ることができます。以下はStyle ReferenceというRAG、ある画像を参考にしてバリエーションを生成するプロセスが一例になります。RAGは思いどおりの生成・デザインコントロールでも使えると言えるでしょう RAGのUse Case RAGの応用は、医療、カスタマーサービス、教育など、さまざまな分野に広がっています。例えば、医療分野では、RAGが広範な医療データベースから得られたエビデンスに基づく推奨を提供することで、医療従事者を支援することができます。 詳細なユースケースの一つは、臨床意思決定支援システム(CDSS)であり、RAGは医療従事者が患者を診断し治療する際に支援します。例えば、医師が特定の病状や治療計画についての質問を入力すると、RAGモデルは関連する医療文献、ガイドライン、および患者データを検索できます。この機能により、AIは患者の独自の状況に応じたエビデンスに基づく推奨を提示することができます。Nature Medicineに発表された研究では、CDSSにRAGを統合することで、ケアの現場でリアルタイムのデータ駆動のインサイトを提供し、診断精度と治療結果の向上につながることが示されています。 さらに、RAGはテレメディスンサービスを強化することができ、チャットボットがパーソナライズされた健康情報を提供することを可能にします。例えば、患者が症状を説明すると、RAGを搭載したチャットボットは関連する医療記事やガイドラインを取得し、ユーザーにカスタマイズされた情報や次のステップを提示します。これにより、患者のエンゲージメントが向上するだけでなく、ケースのトリアージもより効果的に行えるようになります。 まとめると RAGの重要性は過小評価できません。これはAIシステムへの信頼を築くための重要なステップを示しており、AIが一貫した応答を生成するだけでなく、検証された情報に基づくことを確実にします。ハルシネーションの発生を減少させることで、RAGは人間と機械の間のより信頼できるインタラクションを促進し、将来的により高度なAIアプリケーションへの道を開きます。 結論として、AIが私たちの日常生活にますます深く統合されていく中で、Retrieval-Augmented GenerationのようなアプローチはAI開発の進展、精度の向上、ユーザーの信頼の確立において重要です。RAGを受け入れることは選択肢ではなく、人工知能の未来を形作るための必要不可欠な要素です。

RAGの精度向上:チャンクサイズ、クエリ変換、チャンク方法のカスタマイズ

RAG(Retrieval Augmented Generation)は、大規模言語モデル(LLM)の能力を最大限に引き出す強力な手法として注目されています。 RAGは、LLMが外部の知識ベースを参照することで、より正確かつ詳細な応答を生成することを可能にします。しかし、RAGの精度を最大限に引き出すためには、いくつかの重要な要素を最適化する必要があります。 RAG(Retrieval Augmented Generation)の回答精度が低くなる原因としては、主に以下の要素が考えられます。 1. 検索(Retrieval)の精度: 2. 生成(Generation)の精度: 3. その他: これらの原因は複合的に作用することもあり、RAGの回答精度低下の原因を特定し、改善するためには、それぞれの要素を注意深く分析し、適切な対策を講じることが重要です。 本記事では、RAGの精度向上に焦点を当て、チャンクサイズ、クエリ変換、そして具体的なチャンク方法のカスタマイズについて詳しく解説します。 これらの要素を最適化することで、RAGシステムのパフォーマンスを大幅に向上させることができるでしょう。 チャンクサイズの最適化 RAGシステムにおいて、チャンクサイズは非常に重要な要素です。チャンクサイズとは、知識ベースを分割する際の単位となるサイズを指します。 チャンクサイズが適切でないと、RAGシステムは適切な情報を検索できず、不正確な応答を生成してしまう可能性があります。 一般的に、チャンクサイズが小さすぎると、各チャンクに含まれる情報が少なくなり、関連性の高い情報を見つけることが困難になります。一方、チャンクサイズが大きすぎると、各チャンクに含まれる情報が多くなりすぎて、ノイズが増え、検索効率が低下する可能性があります。 最適なチャンクサイズは、知識ベースの内容やLLMの特性によって異なります。 具体的な最適化方法としては、以下のようなアプローチが考えられます。 チャンクの種類と方法 チャンクにはさまざまな種類があり、それぞれに特徴があります。最適な方法を選択するには、知識ベースの内容とLLMの特性を考慮する必要があります。 チャンクの方法としては、正規表現、NLTK、SpaCy、Gensimなどのライブラリを利用する方法があります。 クエリ変換の最適化 RAGシステムにおいて、クエリ変換も重要な要素です。クエリ変換とは、ユーザーが入力したクエリを、知識ベースの検索に適した形式に変換するプロセスを指します。 適切なクエリ変換を行うことで、RAGシステムはより関連性の高い情報を検索し、正確な応答を生成することができます。 具体的なクエリ変換の方法としては、以下のようなものが挙げられます。 最適なクエリ変換方法は、知識ベースの内容やユーザーのクエリの特性によって異なります。 具体的な最適化方法としては、以下のようなアプローチが考えられます。 まとめ 本記事では、RAGの精度向上に焦点を当て、チャンクサイズ、クエリ変換、そして具体的なチャンク方法のカスタマイズについて解説しました。 これらの要素を最適化することで、RAGシステムのパフォーマンスを大幅に向上させることができます。 RAGは、LLMの能力を最大限に引き出すための強力な手法です。チャンクサイズ、クエリ変換、チャンク方法の最適化によって、RAGシステムはさらに進化し、より正確かつ詳細な応答を生成することができるようになるでしょう。 キーワード: RAG, Retrieval Augmented Generation, LLM, 大規模言語モデル, チャンクサイズ, クエリ変換, チャンク方法, 精度向上 メタディスクリプション: RAGの精度向上に焦点を当て、チャンクサイズ、クエリ変換、具体的なチャンク方法のカスタマイズについて詳しく解説します。これらの要素を最適化することで、RAGシステムのパフォーマンスを大幅に向上させる方法を学びましょう。